1. 概述

目前神经网络的编程框架仍然主要使用TensorFlow,尤其在TensorFlow2.0之后,使用TensorFlow框架编程可以像其他Python库一样直接编写。从个人使用角度讲,其优点包括但不限于:

- 隐化计算图构建过程,使得学习壁垒降低,对新手更加友好。

- TensorFlow2.0的Keras API更加好用,可以实现一行一层神经网络,几行完成整个神经网络的设计。

- 梯度计算更加方便,只要设计好神经网络,选定输入和输出神经元,即可自动实现后向传播算法,以计算梯度。

但是,目前主流的TensorFlow存在两个版本,并且两个版本的编程方式存在的不小的差异,为适应复现不用项目的需求,以及学习各种基于神经网络的项目,在本机系统上同时支持两个版本的TensorFlow是有必要的,本教程主要介绍如何在Windows上进行TensorFlow1.x和TensorFlow2.x的同时环境配置。

需要说明的是,TensorFlow1.x是区分CPU版本和GPU版本的,而TensorFlow2.X是不区分的,如果有GPU并配置好了环境会自动搭载GPU运行程序。同时因为TensorFlow1.x的CPU版本较为简单,因此本教程只对TensorFlow1.x和进行TensorFlow2.x的GPU版本进行配置。

2. 基础环境搭建

由于要对双版本的TensorFlow进行支持,这里推荐创建两个Python的虚拟环境(virtualenv)分别安装,并在使用时选择特定的虚拟环境下的Python执行任务。

查看本机是否安装了Python3、pip3、virtualenv。

1 | python3 --version |

如果已经所需的环境包都已经安装,则继续安装Windows系统缺失的动态链接库环境。

包环境安装

- 如果未安装Python3,可以到官网下载并安装,同时pip3会随同Python3一起被安装:Python 3 release for Windows

- 如果未安装virtualenv,可以使用如下命令安装:pip3 install -U pip virtualenv

系统库环境安装

由于TensorFlow2.1.0之后需要Microsoft Visual C++关于Visual Studio 2015, 2017, and 2019的支持。对于未安装 Visual Studio 2019的用户需要另行安装此支持,以实现msvcp140_1.dll对TensorFlow2.1.0的支持。

- 到 Microsoft Visual C++ downloads选取适合自己系统的Visual C++ 2015, 2017 and 2019支持,例如vc_redist.x64.exe。

- 同时保证开启Windows下的长路径许可: long paths are enabled

建立虚拟环境并开启/关闭环境

1 | # 跟新系统环境下的pip |

3. TensorFlow 1.x GPU支持 安装教程

环境配置要求:

1 | scipy==1.2.1 |

更多版本之间的对应关系参考链接https://blog.csdn.net/qq_27825451/article/details/89082978

安装TensorFlow 1.x GPU

1 | # 开启venv_tf_1x_gpu虚拟Python环境 |

配置GPU环境支持

- NVIDIA® GPU drivers —CUDA 10.1 requires 418.x or higher.

- CUDA® Toolkit —TensorFlow supports CUDA 10.0 (TensorFlow = 1.5)

- CUPTI 随同CUDA Toolkit一起安装

- cuDNN SDK (7.4)

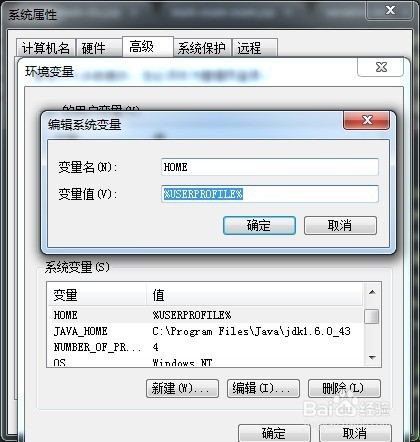

配置系统环境变量

将CUDA, CUPTI, 和 cuDNN加到系统变量%PATH%下。例如,如果CUDA Toolkit 被安装到 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.0 同时cuDNN被安装到 C:\tools\cuda,如下更新%PATH% 以便别的程序能找到他们:

1 | SET PATH=C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.0\bin;%PATH% |

4. TensorFlow 2.x GPU支持 安装教程

环境配置要求:

1 | CUDA==10.1 |

更多版本之间的对应关系参考链接https://blog.csdn.net/qq_27825451/article/details/89082978

安装TensorFlow 2.x GPU

1 | # 开启venv_tf_2x虚拟Python环境 |

配置GPU环境支持

- NVIDIA® GPU drivers —CUDA 10.1 requires 418.x or higher.

- CUDA® Toolkit —TensorFlow supports CUDA 10.1 (TensorFlow >= 2.1.0)

- CUPTI 随同CUDA Toolkit一起安装

- cuDNN SDK (7.6)

配置系统环境变量

将CUDA, CUPTI, 和 cuDNN加到系统变量%PATH%下。例如,如果CUDA Toolkit 被安装到 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.1 同时cuDNN被安装到 C:\tools\cuda2,如下更新%PATH% 以便别的程序能找到他们:

1 | SET PATH=C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.1\bin;%PATH% |

特别注意:两个版本的cuDNN和CUDA不要安装在同一路径,一面相互干扰。

5. 可选操作

更新所有的Python包

可以将系统环境下的大部分Python包更新到最新,以保证大部分包与包之间是兼容的

1 | # pip-review方式: |

1 | # 代码方式 |

声明:本教程写于2020年3月8日,本教程内容只对该日安装过程负责。

主要参考资料:

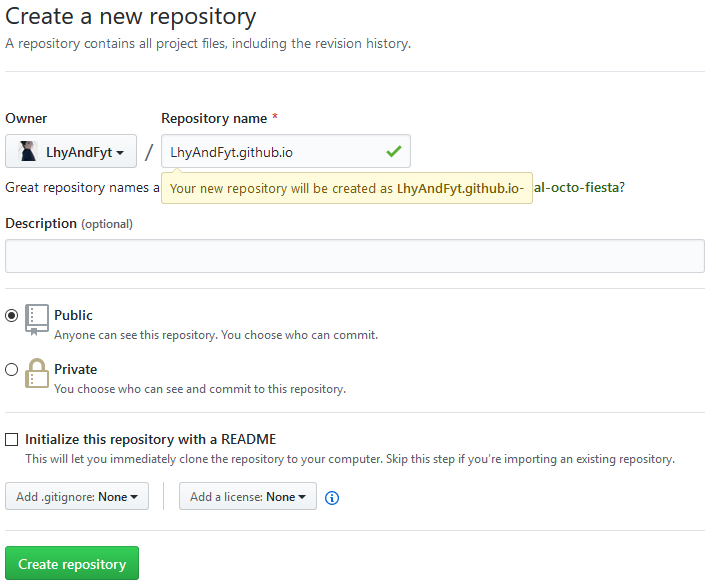

,而其他部分没有这个图像

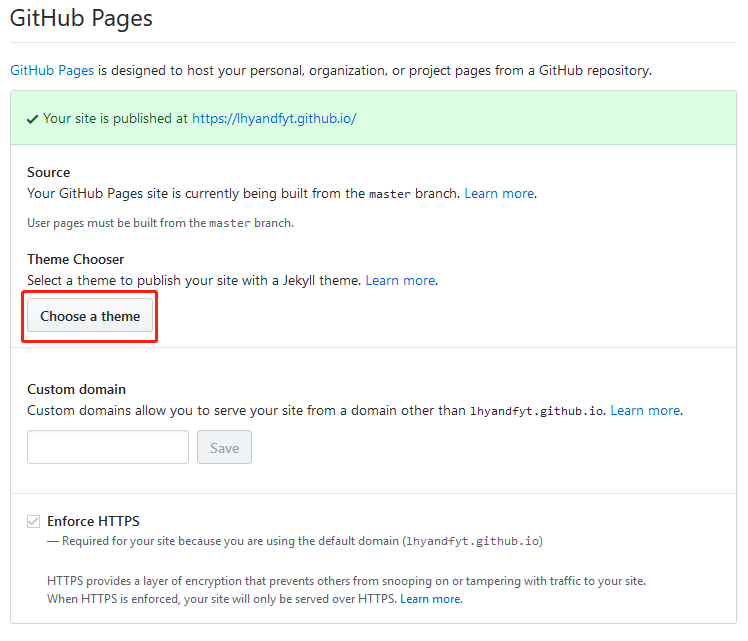

,而其他部分没有这个图像